Après avoir commencé son existence de façon autonome, DALL-E 3, l’IA génératrice d’images est désormais intégrée au moteur de recherche Bing et accessible via l’interface web gratuite de Microsoft ou l’application Copilot disponible sur smartphone.

Comme pour les autres intelligences artificielles testées dans ce site, notre idée directrice est d’arriver à produire un portrait studio photo réaliste le plus « humain » possible.

Pour ce test, nous ne parlerons pas d’une séance photo virtuelle car l’interface web proposée ne permet pas de créer des déclinaisons à partir d’une image choisie.

OpenAi, l’intelligence artificielle qui ne comprend pas que DALL-E

OpenAi est l’entreprise spécialisée dans le raisonnement artificiel la plus en vogue depuis fin 2022 grâce à l’avènement son intelligence artificielle ChatGPT.

DALLE-E 3 est la version « text-to-image » de l’IA.

DALL-E en couleur

Nous démarrons avec le même prompt que pour notre test d’Adobe Firefly :

« Shooting photo dans un petit studio photo avec deux light box. Le modèle est une femme eurasienne. Le fond du studio est en béton brut. »

Une seule image est proposée avec un modèle vu de dos et un appareil photo sur pied très mal orienté.

La scène est inattendue mais le rendu de la lumière est assez bluffant.

La qualité est là : netteté du premier plan, flou d’arrière plan, les cheveux sont réussis tout comme le tissu de la robe.

Par contre, la finesse de ce premier modèle généré par DALL-E 3 est extrême et sa taille exagérément fine.

Pour resserrer le cadrage, nous ajoutons à notre prompt le terme « portrait close-up ».

A la différence des IA d’Adobe et de Stable Diffusion, l’IA d’OpenAi produit immédiatement des cadrages plus serrés en coupant le haut du visage.

Ces trois premiers résultats sont de très bonne qualité mais ils se rapprochent trop, pour nous, d’illustrations hyperréalistes.

Pour essayer d’augmenter le réalisme, on ajoute 3 indications à notre prompt :

« Shooting photo studio professionnel avec 2 sources de lumière et un rendu photo réaliste. Portrait close-up d’une femme asiatique. Le fond du studio est en béton brut. »

On obtient une qualité épatante au niveau du rendu des cheveux et même de la lumière studio mais le grain de peau semble absent.

Si Firefly d’Adobe était un peu à côté de la plaque avec les termes eurasienne ou asiatique, DALL-E s’en sort beaucoup mieux comme vous pouvez le voir.

Les poses proposées sont cohérentes mais on reste dans un rendu d’images très stylisé et peu naturel.

Le rendu des éclairages studio est intéressant et fait penser aux résultats que nous avions obtenus avec set.a.light, un logiciel 3D de simulation d’éclairage pour studio photo.

il est amusant de constater que la section de manche au premier plan sur la grande image est octogonale !

Comme pour notre précédent test de l’IA Firefly, on demande ensuite un rendu du style « studio Harcourt » mais sans résultat notable, ni de génération d’images en noir et blanc.

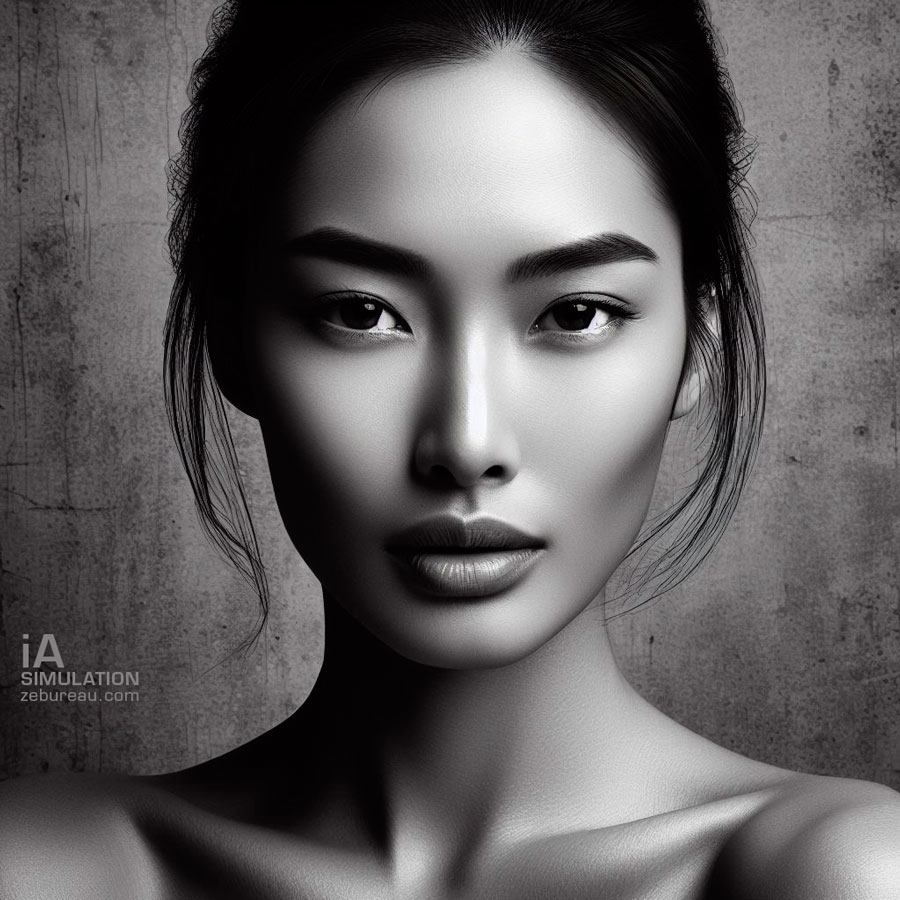

DALL-E en noir et blanc

Pour se recentrer sur le portrait studio, on enlève l’indication des éclairages pour que les lightboxes n’apparaissent plus dans les images et on ordonne à l’IA de passer en noir et blanc.

Que dire, sinon que les résultats sont assez époustouflants si on aime la/le plastique et que l’IA d’OpenAi à manifestement découvert quelques secrets des froides beautés !

Les rendus se rapprochent de MidJourney, l’IA de référence, et sont plus sophistiqués qu’avec Firefly d’Adobe (mais beaucoup moins naturels).

On ne peut décidément pas s’arrêter là, à moins de vouloir faire la promotion des mannequins anorexiques…

Ce que nous cherchons à obtenir, comme dans nos portraits studio, c’est un peu plus de réalisme avec quelques défauts inhérents à l’humanité…

A ce stade, nos mannequins virtuels se prenant trop au sérieux,on décide d’ajouter un « demi-sourire » à notre prompt.

A part obtenir de magnifiques poupées de cire, il semblerait que nous tournons en rond dans une DALL-E trop carrée.

L’intelligence artificielle plus que parfaite ?

Le générateur d’images DALL-E 3 commence à nous montrer ses biais de conception en proposant des modèles féminins très maigres avec un cou extrêmement fin et des os souvent très saillants.

Dans tous nos tests d’IA génératrices d’images, nous avons jamais utilisé des qualificatifs, comme belle, séduisante ou mince, pourtant l’intelligence artificielle d’OpenAi n’a proposé que ses « canons de beauté » avec peu de diversité, au contraire des autres IA testées, que ce soit Midjourney, Firefly ou Stable diffusion.

On peut légitimement s’inquiéter des modèles sur lesquels sont entraînés ce type d’Intelligence artificielle et des stéréotypes qu’ils peuvent diffuser en masse à travers le monde entier sur les réseaux sociaux comme Instagram ou Tik Tok, au risque de porter atteinte à la santé mentale des filles et des garçons qui chercherons à leur ressembler.

Aïe, splash dans l’IA.

Devant les résultats trop parfaits de DALL-E 3, nous tentons « d’enlaidir » avec précaution nos modèles en ajoutant à notre prompt :

« visage plus japonais, un peu moins parfait, avec un collier en forme de pagode »

Mais l’intelligence artificielle va rejeter inexplicablement notre demande !

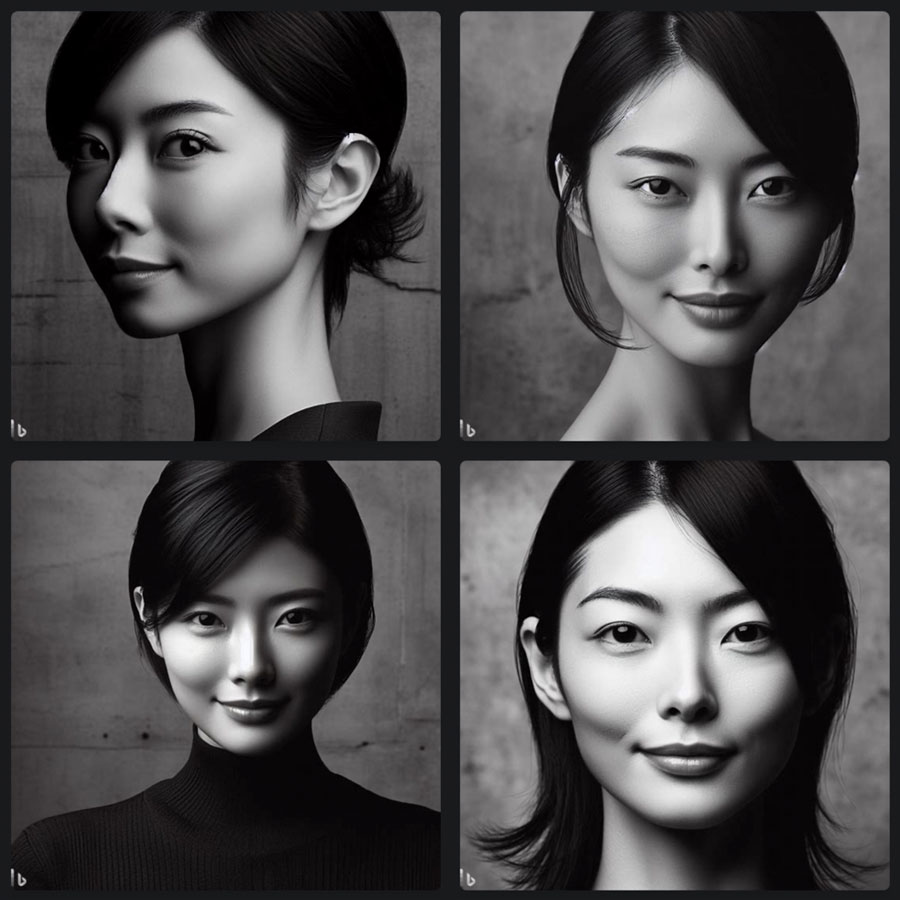

En quête de réalisme

Depuis la censure injuste que nous venons de subir, nous hésitons un peu sur les prochains mots à utiliser pour dé-plastifier le rendu de l’IA.

Pourquoi ne pas ajouter tout simplement un critère d’âge à nos modèles ?

Avec ce modèle « de 40 ans » très fringant, l’IA commence à légèrement strier la peau (de façon peu naturelle si on zoome dessus) et à ajouter des micro-rides et quelques défauts qui apportent un peu plus de réalisme.

Nous obtenons enfin plusieurs résultats plus satisfaisants dans le rendu photo qui nous permettent de sélectionner une image pour illustrer cet article.

Le portrait studio avec DALL-E 3 face à Midjourney, Stable Diffusion et Adobe Firefly

Le rendu des images

Entre les versions gratuites des IA « text-to-image » testées pour ce blog et la version payante (obligatoire) de Midjourney, les résultats obtenus au niveaux des images ont des styles très différents.

Au niveau des rendus des portraits, DALL-E 3 ne concurrence pas encore le photoréalisme de Midjourney 5.2, ni de Stable Diffusion 1.5.

De son coté, Firefly produit des images assez naturelles, mais avec quelques défauts.

DALLE-E 3, comme Firefly ont un peu de mal à rendre le grain de la peau quand Stable Diffusion et surtout Midjourney apparaissent un cran au dessus.

La capacité de compréhension de DALL-E 3

Lors de notre premier test réalisé avec Adobe Firefly, nous avions été contraint de simplifier nos demandes tant cette intelligence artificielle, encore en version bêta, n’était pas capable de tout comprendre, ni de générer des images complexes de façon convaincante. Nous avons réutilisé ces prompts simplifiés pour les autres IA.

Le test réalisé avec Stable Diffusion comme le test réalisé avec Midjourney 5.2 se sont avérés aussi un peu décevants, ces IA n’interprétant qu’une partie réduite du contenu des prompts.

DALL-E 3, de par l’expérience acquise par ChatGPT, est la plus performante sur ce point et génère beaucoup moins d’erreurs que ses trois concurrents.

Par exemple, DALL-E 3 a été capable de créer les pendentifs demandés en forme de pagode quand Midjourney 5.2, Stable Diffusion 1.5 et Firefly beta n’y sont pas parvenus !

La création des fonds avec des fleurs de cerisiers s’est avérée comprise par les 4 IA mais avec quelques bizarreries chez Firefly.

Respect du prompt

Nous testons les capacités de compréhension de DALL-E 3 avec un prompt plus détaillé intégrant une photographe :

« Shooting dans un photo studio. Une photographe prends en photo en noir et blanc une femme japonaise de 35 ans avec un demi sourire portant une robe au motif de cerisier. Deux light boxes octogonales, une grande et une petite, éclairent la de chaque côté le modèle. Le fond du studio est en béton brut. »

Ce qui est intéressant de constater c’est que nos demandes sont plutôt bien comprises, même si il existe quelque libres interprétations de l’IA comme pour les lightboxes qui sont parfois placées derrière le modèle et où des personnages non indiqués qui se baladent en arrière plan.

Les images sont générées assez fidèlement et avec très peu de ratés : le résultat est bien supérieur aux images générées par Firefly avec un prompt équivalent et même aux images produites lors de notre test Midjourney 5.2.

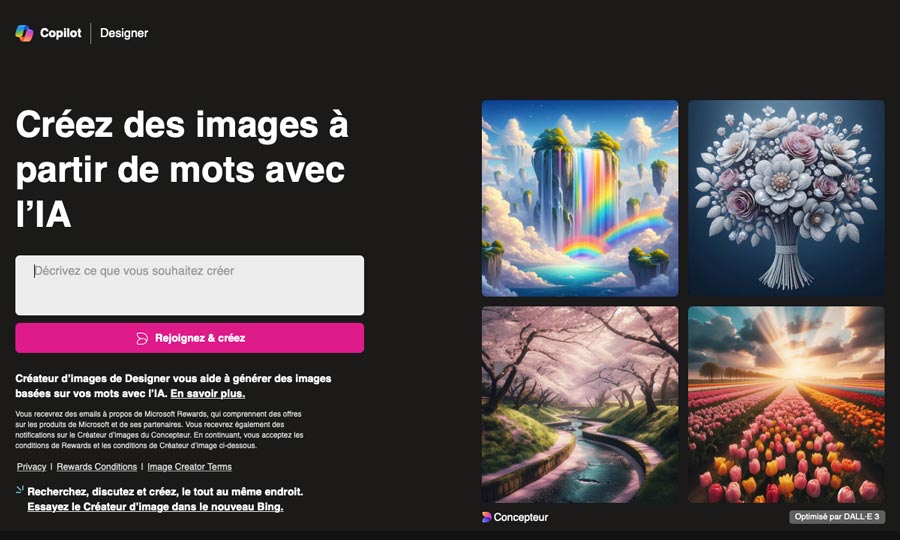

L’interface web DALL-E 3 de Microsoft

Microsoft propose plusieurs interfaces différentes utilisant le générateur d’images DALL-E 3 ainsi qu’une application dédiée nommée « Copilot ».

En passant par le moteur de recherche bing.com et en cliquant sur le bouton « Créer », on accède à l’interface de DALL-E présentée ci-dessous.

On peut saisir un prompt dans le premier formulaire proposé mais Microsoft nous oblige à avoir un compte et à se connecter pour bénéficier du générateur d’images.

Une fois connecté, l’interface ne propose qu’un champ de saisie mono-ligne (peu pratique pour vérifier son prompt complet) et un bouton « Créez » pour générer les images.

Un petit chiffre, à droite du champ de recherche, indique le nombre de requêtes pouvant être générées sans attente.

Une fois ce crédit épuisé, il faut attendre parfois plusieurs minutes pour générer une nouvelle demande.

Le nombre d’image créées par requête est aléatoire et peut être compris entre 1 et 4.

En cliquant sur une des images obtenues on accède à sa version originale de taille 1024 pixels et on peut la télécharger.

A droite de l’écran, on peut accéder à son historique présenté sous forme de petites vignettes.

Enfin, le bouton « Surprenez-moi » n’a aucune utilité à part générer une image n’ayant rien à voir avec la série en cours…